Ogni Pillo(w)la ha la sua “copertina”

Il tema della ventunesima Pillo(w)la è strettamente collegato alla precedente: nella copertina n. 20 abbiamo parlato delle opportunità offerte dall’IA utilizzando i dati dei cittadini; ora, invece, ci concentreremo sui rischi generati dalla condivisione di informazioni sensibili. Ci troviamo sempre all’interno della PA Factory, ma sembrerebbe essere accaduto qualcosa: un attacco hacker! PA Empatica, infatti, sta chiedendo aiuto a DataMan per risolvere al più presto la situazione. All’improvviso, però, la funzionaria si toglie la maschera e svela la sua vera identità: è DataGoblin! Infatti, il nuovo SuperCattivo ha il potere di rubare l’identità delle persone, manipolare i dati, generare attacchi hacker e lanciare virus; dal suo corpo escono cavi USB per connettersi a qualsiasi dispositivo ed è in grado di cambiare volto per non farsi riconoscere. Ma non solo! Ha a sua disposizione una serie di mezzi di trasporto da utilizzare a seconda dell’attacco che sta meditando, per esempio, il suo DataBoard gli consente di trasportarsi velocemente da un posto all’altro. Le sorprese, però, non finiscono qua: DataGoblin in realtà è il fratello di DataMan. Chi vincerà questa guerra fratricida?

Quali sono i rischi nella condivisione dei propri dati con l’IA? Come possiamo tutelarci?

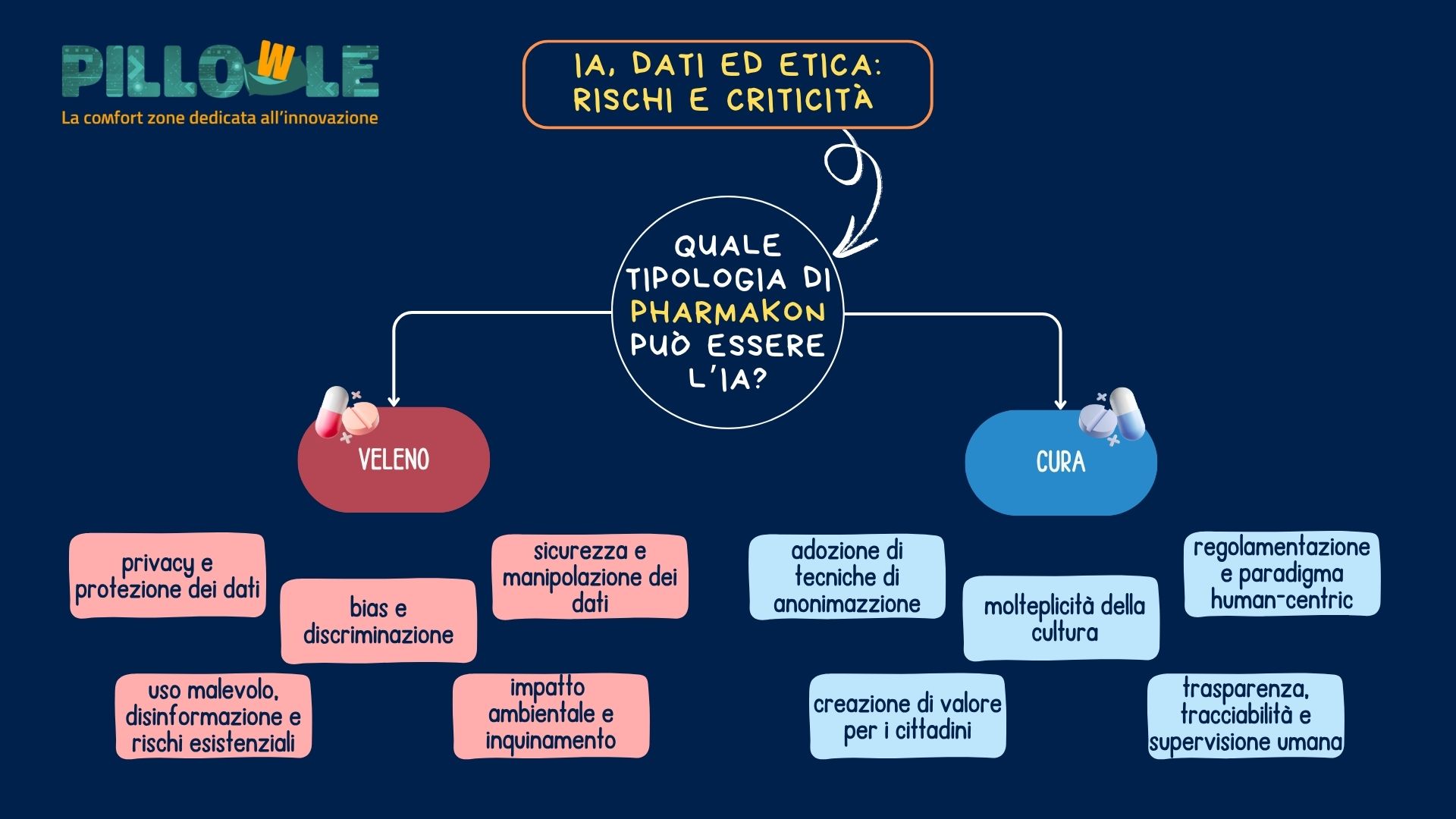

L’Intelligenza Artificiale può essere considerata come il pharmakon di Platone [1], rimedio e veleno: può migliorare le nostre vite, ma allo stesso tempo, se non utilizzata correttamente, nascondere pericoli e generare problemi. Per tale motivo, nella Pillo(w)la precedente abbiamo parlato dei vantaggi dell’utilizzo dei dati da parte dell’Intelligenza Artificiale, esaminando i settori che più potrebbero trarne beneficio. Ora, invece, analizzeremo l’IA come “veleno”: affidare informazioni sensibili ad una tecnologia così invasiva cela alcuni rischi da non sottovalutare e problemi legati all’etica e all’impatto ambientale, quali?

Privacy e protezione dei dati

L’IA richiede l’accesso a grandi quantità di dati, spesso sensibili. Ciò solleva preoccupazioni riguardo alla privacy, soprattutto quando si utilizzano dati personali senza un adeguato consenso. La letteratura suggerisce l’adozione di tecniche di anonimizzazione, differential privacy e apprendimento federato come soluzioni parziali. [2]

Bias e discriminazione

Come abbiamo visto nella Pillo(w)la 4, i modelli di IA possono perpetuare o amplificare pregiudizi presenti nei dati di addestramento, portando a decisioni discriminatorie in ambiti come l’occupazione, la giustizia e l’accesso ai servizi. I dati raccolti riflettono inevitabilmente le disuguaglianze storiche, culturali e sistemiche presenti nella società. Esistono diverse tipologie di bias che dobbiamo considerare: di contesto, del programmatore e quelli insiti all’interno dei dati. Una soluzione potrebbe essere individuata nella molteplicità della cultura, ovvero la costituzione di gruppi di lavoro diversificati in base al genere, all’età e all’etnia.

Sicurezza e manipolazione dei dati

I sistemi di IA sono suscettibili ad attacchi informatici che possono manipolare i dati o il comportamento del modello, con potenziali conseguenze dannose. Tali minacce sono particolarmente pericolose in settori sensibili come la difesa, la finanza e la mobilità. Studi del Belfer Center hanno mostrato come la crescente dipendenza dai dati renda i sistemi intelligenti un bersaglio strategico per attori ostili. [3]

Impatto ambientale

Secondo il MIT, l’addestramento e l’esecuzione di modelli di IA – specialmente di grandi dimensioni – richiedono notevoli risorse energetiche, contribuendo alle emissioni di gas serra e al consumo di acqua. [4]

Uso malevolo e rischi esistenziali

L’Intelligenza Artificiale può essere utilizzata per scopi malevoli, come la creazione di deepfake, la diffusione di disinformazione e fake news, rappresentando una minaccia significativa per la sicurezza globale.

Di fronte a questo scenario, la comunità scientifica e gli organi politici sono chiamati a intervenire con urgenza per regolamentare l’uso dei dati da parte dell’Intelligenza Artificiale, bilanciando le esigenze di innovazione con la tutela dei diritti fondamentali. In Europa, l’AI Act propone una classificazione dei sistemi di IA in base al rischio, prevedendo obblighi specifici di trasparenza, tracciabilità e supervisione umana. Sul piano etico, si afferma la necessità di un paradigma human-centric, secondo cui la tecnologia deve essere sviluppata e utilizzata nel rispetto della dignità e dell’autonomia dell’essere umano.

In sintesi, è necessario cominciare a capire che siamo noi a scegliere cosa delegare all’Intelligenza Artificiale e cosa mantenere di nostra competenza, cosa condividere o cosa no. In altre parole, la domanda che dobbiamo porci non deve concentrarsi su cosa può accadere se condividiamo i nostri dati con l’IA; è fondamentale, invece, capire dove la tecnologia può creare valore o disvalore. Come può l’Intelligenza Artificiale migliorare le nostre vite e quale pharmakon può essere? Questa è la vera sfida che dobbiamo affrontare.

[1] In greco antico, il termine pharmakon (φάρμακον) ha un doppio significato: indica sia una medicina sia un veleno. Questo rende il pharmakon una figura ambivalente, in grado di essere sia benefico che dannoso, a seconda del contesto e dell’uso. Nel Fedro, Platone utilizza tale concetto per analizzare la scrittura, che – secondo lui – può sicuramente essere uno strumento prezioso per diffondere il sapere e per memorizzare informazioni, ma allo stesso tempo nascondere dei rischi. Platone non si oppone alla scrittura in sé, bensì evidenzia l’importanza di utilizzarla con consapevolezza.

[2] IBM, Exploring privacy issues in the age of AI. (2023) Disponibile al link.

[3] Belfer Center, Attacking Artificial Intelligence. (2021) Disponibile al link.

[4] MIT, Explained: Generative AI and its environmental impact. (2025) Disponibile al link.