Ogni Pillo(w)la ha la sua “copertina”

Nella quarta Pillo(w)la viene approfondito il tema dei rischi nell’utilizzo dell’Intelligenza Artificiale all’interno della Pubblica Amministrazione. La PA empatica viene rappresentata come una catena di montaggio: il processo inizia con la creazione di un servizio, ancora allo stato grezzo, che nella fase seguente è corretto da eventuali errori e bias. A questo punto i servizi approvati vengono sottoposti all’IA: Dataman li moltiplica e Generadiva li migliora. Successivamente, il Supervisore riceve i nuovi servizi e verifica che non ci siano bias generati dall’IA. Infine, la PA rappresentata da un impiegato, prende il prodotto definitivo e lo mette al servizio del cittadino, andandogli incontro e anticipandone i bisogni

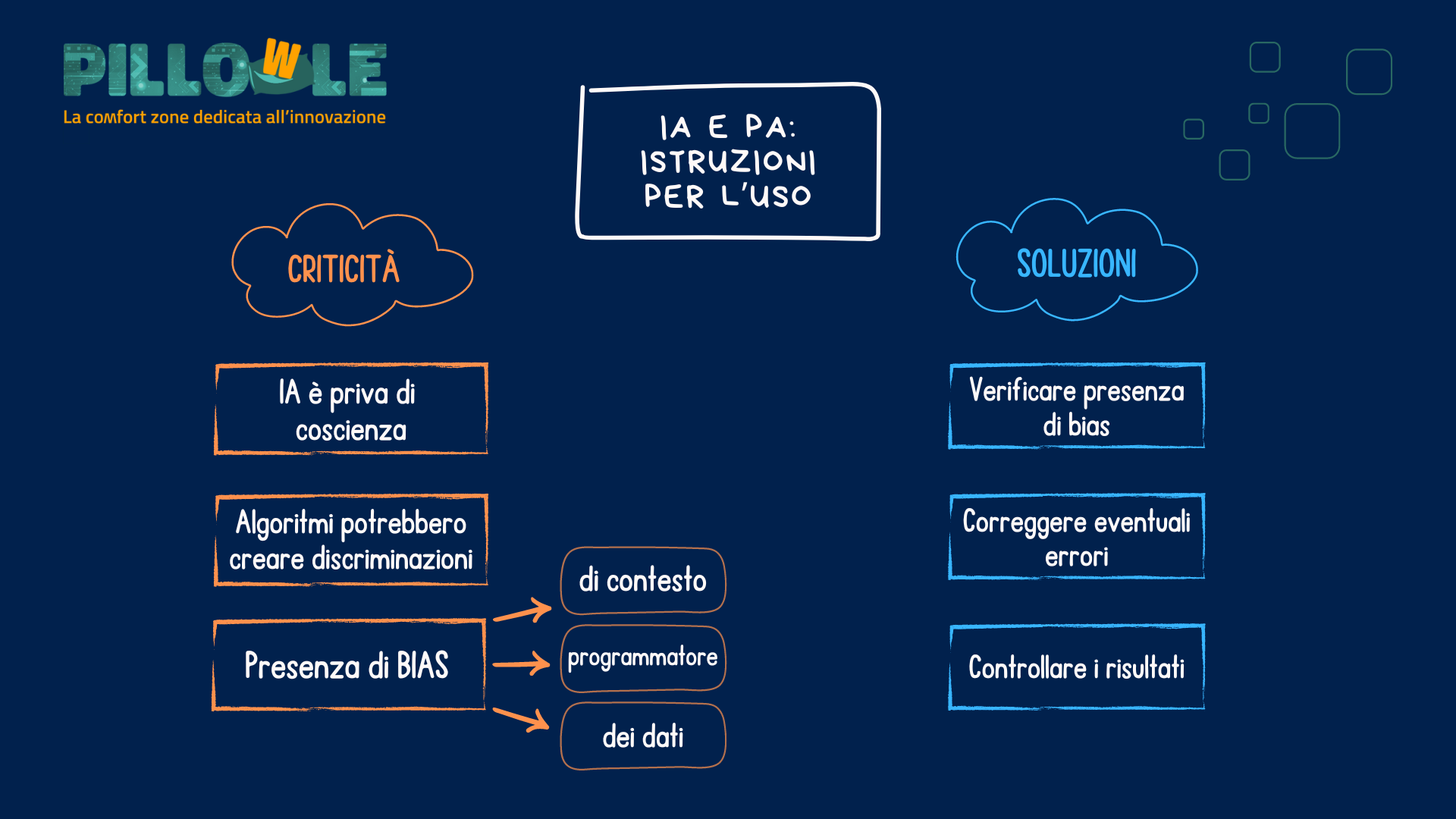

Quali sono i rischi nell’utilizzo dell’Intelligenza Artificiale all’interno della Pubblica Amministrazione?

L’Intelligenza Artificiale può essere utilizzata anche nella Pubblica Amministrazione seguendo il modello del Post-Digital Government: impiegare i dati per creare valore per i cittadini, anticipandone i bisogni e prevenendo gli eventi.

Ma l’uso dell’Intelligenza Artificiale nella Pubblica Amministrazione cela anche alcuni rischi e criticità che riguardano, nello specifico, l’avvalersi delle informazioni presenti nelle sue banche dati. Gli algoritmi, infatti, rischiano di esasperare – anziché superare – alcune forme di disuguaglianza o discriminazione.

A tal proposito è interessante citare un articolo di Bloomberg [1] nel quale si riflette su come l’IA generativa elabori i volti delle persone associandoli alle professioni lavorative. Dalla sua ricerca è emerso, infatti, che a figure più alte in grado – come manager, direttori ecc. – vengono associati volti di uomini bianchi, mentre le professioni come gli addetti alle pulizie sono associate a donne ispaniche.

Ne consegue che se noi utilizzassimo in questo modo l’Intelligenza Artificiale – non controllando ciò che viene prodotto – potremmo replicare e consolidare alcune ingiustizie. In tal senso, è opportuno ricordare che le macchine sono prive di coscienza perché svolgono una mera analisi dei dati, rischiando di cadere in alcuni bias.

Esistono tre tipologie di bias pericolosi. La prima fa riferimento al contesto: gli algoritmi e l’IA ne sono privi e non lo riconoscono. Si comportano nello stesso modo a prescindere dal contesto in cui vengono lanciati basandosi sulla cultura in cui sono stati creati. La seconda tipologia di bias riguarda i pregiudizi dei programmatori, i quali sono incorporati direttamente all’interno dell’algoritmo. Infine, la terza categoria di bias comprende i pregiudizi sociali insiti nei dati: se non vengono aggiunti filtri o considerazioni, l’algoritmo farà una mera replica – o addirittura un potenziamento – delle ingiustizie presenti nel sistema sociale di riferimento.

Quali sono le istruzioni da seguire per un corretto utilizzo dell’IA? Le pubbliche amministrazioni possono avvalersi del paradigma del Post-Digital Government per essere in prima linea nel promuovere un uso affidabile dell’IA, mettendo l’essere umano al centro. La PA, infatti, deve essere in grado di migliorare l’efficienza, il processo decisionale e la fornitura di servizi, affrontando al tempo stesso le preoccupazioni relative all’etica, alla trasparenza e alla responsabilità nell’utilizzo degli strumenti di intelligenza artificiale. [2]

Nello specifico, la vera sfida per la Pubblica Amministrazione, nell’era post-digitale, sta nel cominciare a controllare ciò che viene prodotto dall’ IA verificando che non ci siano bias, gli algoritmi risultino corretti e i risultati siano quelli attesi. Si tratta, in sostanza, di correggere tutti gli errori insiti nei bias per non creare disuguaglianze o discriminazioni ed utilizzare correttamente i dati.

[1] “HUMANS ARE BIASED. GENERATIVE AI IS EVEN WORSE” di Leonardo Nicoletti and Dina Bass per Bloomberg Technology + Equality, 9 Giugno 2023

https://bloomberg.com/graphics/2023-generative-ai-bias/

[2] “AI IN PUBLIC SETTINGS: STATUS AND NEXT STEPS” di Luca Gastaldi, Michele Petrocelli, Loredana Rinaldi and Andrea Rollin, Economic and Financial analysis and planning, Ministry of Economy and Finance – Department of the Treasury, Febbraio 2024

https://www.dt.mef.gov.it/export/sites/sitodt/modules/documenti_it/analisi_progammazione/note_tematiche/Nota-Tematica-n-1-February-2024.pdf